语言模型(Language Model,LM),给出一句话的前k个词,希望它可以预测第k+1个词是什么,即给出一个第k+1个词可能出现的概率的分布p(xk+1|x1,x2,...,xk)。

PPL: Perplexity

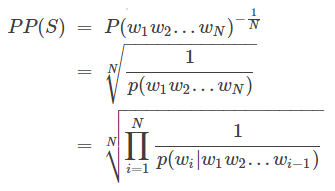

PPL是用在自然语言处理领域(NLP)中,衡量语言模型好坏的指标。它主要是根据每个词来估计一句话出现的概率,并用句子长度作normalize,公式为

S代表sentence,N是句子长度,p(wi)是第i个词的概率。第一个词就是 p(w1|w0),而w0是START,表示句子的起始,是个占位符。

这个式子可以这样理解,PPL越小,p(wi)则越大,一句我们期望的sentence出现的概率就越高

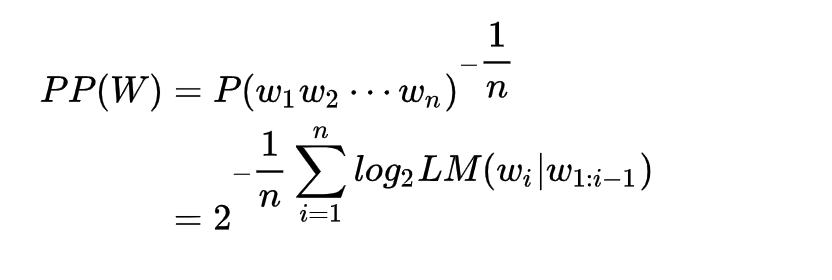

Perplexity另一种表达

BERT as language model

首先bert是一个masked language model,因此只能在句子中有mask的时候根据双向的词来预测这个位置的单词,不符合语言模型的链式法则,但是也是可以一个一个的mask掉单词,然后得到去掉这个单词之后 句子的得分,然后将所有的得分相加得到句子的困惑度

GPT as language model

GPT2本质是上一个语言模型,那么对于训练好的Model,给定一段文本,应该可以计算这段文本的得分或者困惑度(Perplexity),这也是传统语言模型的应用场景之一

来源:今日头条(剑指天涯)

相关文章

暂无评论...